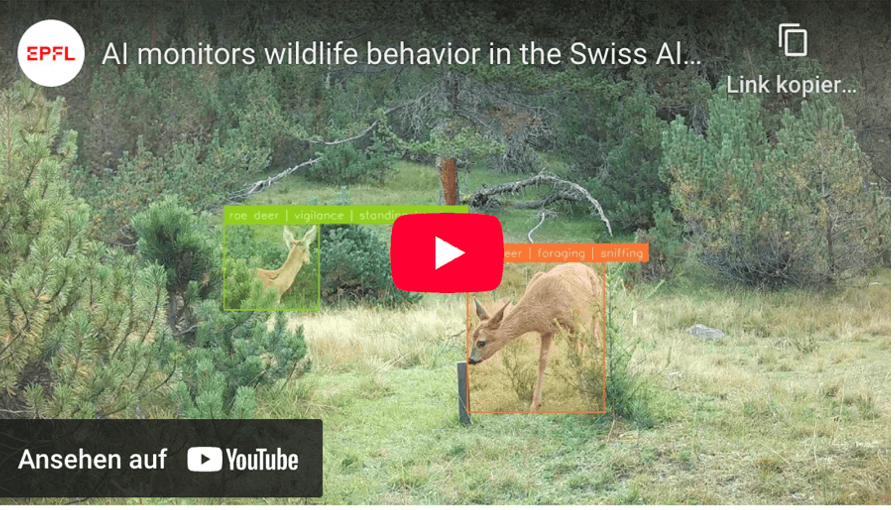

Haben Sie sich schon einmal gefragt, wie sich Wildtiere verhalten, wenn niemand zuschaut? Das Verständnis natürlicher Verhaltensweisen ist entscheidend für den Schutz von Ökosystemen, insbesondere da der Klimawandel und menschliche Ausbreitung natürliche Lebensräume verändern. Doch das Sammeln solcher Informationen, ohne die Tiere dabei zu stören, war schon immer eine Herausforderung.

Traditionell setzten Forschende auf direkte Beobachtungen oder an Tieren befestigte Sensoren – Methoden, die entweder störend oder in ihrer Reichweite beschränkt sind. Sogenannte Kamerafallen bieten eine weniger invasive Alternative, erzeugen aber große Mengen an Filmmaterial, dessen Analyse äußerst zeitaufwändig ist.

KI könnte hier Abhilfe schaffen, doch es gibt einen Haken: Sie benötigt annotierte Daten zum Lernen. Die meisten Datensätze stammen heute entweder aus dem Internet, wodurch die Authentizität einer natürlichen Umgebung nicht gegeben ist, oder es handelt sich um wenig umfangreiche Feldaufnahmen ohne Detailgenauigkeit. Und nur wenige verfügen über einen reichhaltigen Kontext – wie mehrere Kameraperspektiven oder Audiomaterial –, der notwendig ist, um komplexes Tierverhalten wirklich zu verstehen.

Wir stellen vor: MammAlps

Um dieser Herausforderung zu begegnen, entwickelten EPFL-Forschende in Zusammenarbeit mit dem Schweizerischen Nationalpark MammAlps, den ersten umfangreich annotierten Videodatensatz, zum Verhalten von Wildtieren mit mehreren Perspektiven und Erfassungsmethoden. MammAlps wurde entwickelt, um KI-Modelle für die Erkennung von Tierarten- und Verhaltensweisen zu trainieren und letztlich Forschenden dabei zu helfen, Tierverhalten besser zu verstehen. Diese Arbeit könnte die Naturschutzbemühungen effizienter, kostengünstiger und intelligenter gestalten. MammAlps wurde vom Doktoranden Valentin Gabeff unter der Leitung der Professoren Alexander Mathis und Devis Tuia, gemeinsam mit ihren jeweiligen Forschungsteams entwickelt.

Wie MammAlps entstanden ist

Die Forschenden stellten neun Kamerafallen auf, die über mehrere Wochen mehr als 43 Stunden Rohmaterial aufzeichneten. Das Team verarbeitete sie anschliessend sorgfältig und nutzte KI-Tools, um einzelne Tiere zu erkennen und zu verfolgen. Das Ergebnis waren 8,5 Stunden Videomaterial mit Wildtierverhalten.

Verhaltensweisen wurden mithilfe eines hierarchischen Ansatzes annotiert und jeder Augenblick auf zwei Ebenen erfasst: übergeordnete Aktivitäten wie Futtersuchen oder Spielen und untergeordnete Handlungen wie Gehen, Fellpflege oder Schnüffeln. Mit dieser Struktur können KI-Modelle Verhaltensweisen genauer interpretieren, indem sie detaillierte Bewegungen mit umfassenderen Verhaltensmustern verknüpfen. Um den KI-Modellen einen umfassenderen Kontext zu bieten, ergänzte das Team die Videoaufnahmen mit Ton und erstellte sogenannte «Referenzkarten», welche Umweltfaktoren, wie Wasserquellen, Büsche, Felsen dokumentieren. Diese zusätzlichen Daten ermöglichen eine präzisere Interpretation von habitat-spezifischen Verhaltensweisen. Auch Wetterlage und Anzahl der beobachteten Tiere flossen in die Szenenbeschreibung ein, um ein detailreicheres Gesamtbild zu schaffen.

«Indem wir neben Videoaufnahmen auch Ton und andere Modalitäten einbeziehen, konnten wir zeigen, dass KI-Modelle Tierverhalten besser erkennen können», erklärt Alexander Mathis. «Dieser multimodale Ansatz liefert uns ein um fangreicheres Verständnis des Wildtierverhaltens.»