Sei es die Flugreise, das Heizen der Wohnung oder auch nur das Streamen der Lieblingsserie – wer sich für seinen ökologischen Fussabdruck interessiert, kommt heute meistens ohne grossen Aufwand an Informationen über den eigenen Energieverbrauch. Ausgerechnet bei der künstlichen Intelligenz mit ihren energiehungrigen neuronalen Netzwerken ist das nicht so einfach.

Der Endnutzer kann kaum einschätzen, wie viel Energie etwa eine Antwort von Chat-GPT kostet. Nicht einmal die KI-Entwickler wissen in der Regel im Detail über den Energieverbrauch ihrer Schöpfungen Bescheid.

«Solange man den Energieverbrauch nicht misst, kann man ihn auch nicht effektiv senken», sagt Stefan Naumann, Professor für Nachhaltigkeitsinformatik am Umwelt-Campus Birkenfeld der Hochschule Trier. Gemeinsam mit seinen Kollegen hat er es sich zum Ziel gesetzt, den Energiebedarf von Kl-Systemen zu quantifizieren und zu optimieren.

Schon jetzt ist die gesamte Informations- und Kommunikationstechnik laut Schätzungen für 2 bis 4 Prozent der globalen Treibhausgasemissionen verantwortlich. Damit liegt sie etwa im Bereich des weltweiten Flugverkehrs. «KI ist der neue Treiber in diesem Bereich geworden», sagt Naumann. «Denn vor allem das Training der neuronalen Netze benötigt viel Energie.»

Aufwendiges Training

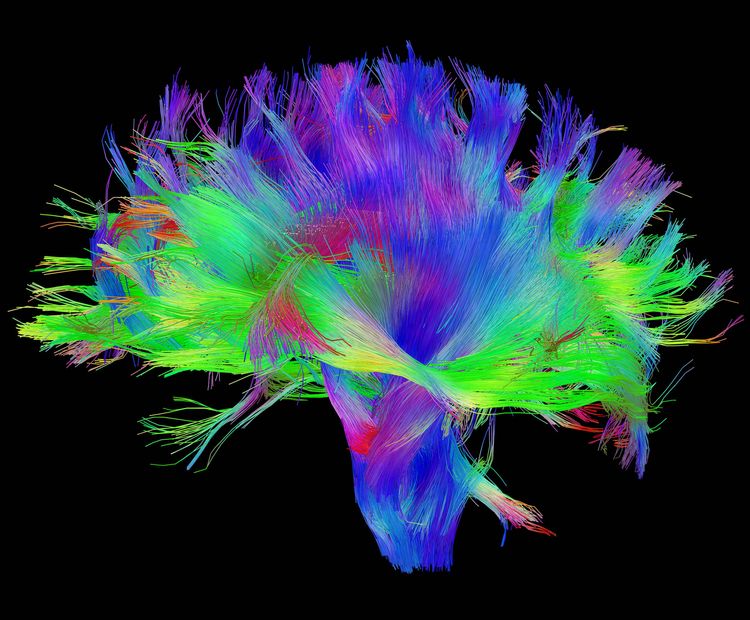

Während der Trainingsphase erlernen etwa die grossen Sprachmodelle, die hinter Anwendungen wie Chat-GPT stecken, anhand riesiger Datenmengen die Strukturen menschlicher Sprache. Dafür optimieren sie in langwierigen Prozessen Schritt für Schritt die oft vielen Milliarden Parameter ihrer künstlichen neuronalen Netze. Und da die Grösse der Modelle rasant wächst, explodiert auch der Rechenaufwand.

Im Extremfall sind es laut Naumann Tausende vernetzter Prozessoren, die in riesigen Rechenzentren mehrere Wochen lang laufen und Hunderttausende Euro an Stromkosten verursachen, bis ein Training abgeschlossen ist. So sollen für das Training des GPT-3-Modells geschätzt 1287 Megawattstunden aufgewendet worden sein. Das entspricht etwa der Menge an Strom, die ein mittleres Atomkraftwerk in einer Stunde produziert.

Die Tech-Firmen verraten keine Details

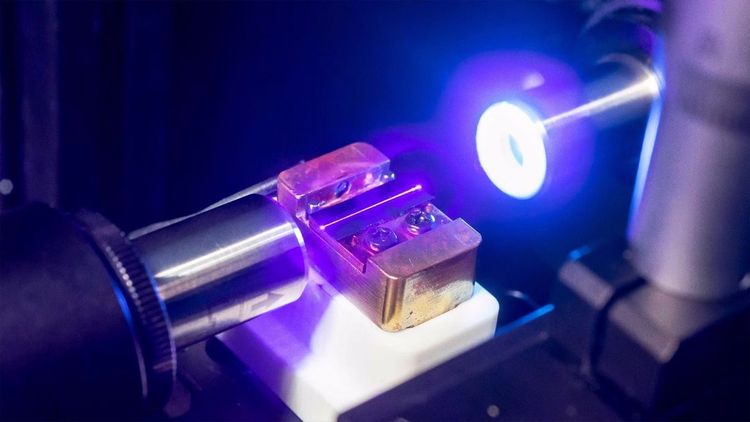

Doch so eindeutig der Anstieg des Gesamtstromverbrauchs ist, so wenig ist derzeit über die Energieeffizienz auf Ebene einzelner Prozessoren oder gar einzelner Berechnungen bekannt. Deshalb führen Naumann und sein Team auf ihren eigenen Computern Experimente mit kleineren Modellen durch und versuchen, den Stromverbrauch so exakt und detailliert wie möglich zu bestimmen.

Und auch grosse Sprachmodelle werden bereits zu Forschungszwecken unter die Lupe genommen. So hat etwa das KI-Startup Hugging Face detaillierte Daten zum Stromverbrauch seines 176 Milliarden Parameter umfassenden Sprachmodells Bloom veröffentlicht.

Die Informationen sollen in Zukunft dabei helfen, die zur Verfügung stehenden Rechenkapazitäten optimal zu nutzen. Schliesslich ist die Energieeffizienz eines Rechenzentrums am grössten, wenn alle Prozessoren optimal ausgelastet sind.

In der Realität ist die Auslastung allerdings deutlich niedriger, weil einzelne Prozessoren vorübergehend immer wieder auf die Zuteilung einer neue Rechenaufgabe warten müssen. So wie ein eingeschalteter PC, der unbeachtet auf dem Schreibtisch steht, verbrauchen auch sie in dieser Zeit Strom, ohne dafür Leistung zu erbringen.

Im Fall des Trainings von Bloom hat sich etwa herausgestellt, dass lediglich etwas mehr als die Hälfte der Energie tatsächlich in die Ausführung des Codes ging. Ein Drittel wurde für leerlaufende Rechner verschwendet, und der Rest entfiel auf die allgemeine Infrastruktur des Rechenzentrums wie etwa den Betrieb des Kühlsystems.

Der Boom seit Chat-GPT erhöhte den Energieverbrauch

Auch wenn ein Modell fertig trainiert ist, geht der Energiebedarf weiter: mit jeder Anwendung. Zwar braucht eine einzelne Chat-Anfrage nach einer Schätzung des Datenwissenschafters Alex de Vries nicht mehr Energie als eine Nachttischlampe, die für ein paar Stunden leuchtet. Anderseits hat allein Chat-GPT bei seiner Einführung innerhalb von nur zwei Monaten stolze 100 Millionen neue Nutzer gefunden und wendete laut Schätzungen jeden Tag über 500 Megawattstunden an Strom auf, um den Dienst am Laufen zu halten. Damit könnte ein sparsames Elektroauto hundertmal die Erde umrunden.

Inzwischen ist Chat-GPT in Microsofts Suchmaschine Bing integriert. «Zum Energieverbrauch des neuen Systems hält man sich bei Microsoft aber noch ziemlich bedeckt», sagt Naumann. Würden wiederum alle der 9 Milliarden täglichen Suchanfragen bei Google von einem Sprachmodell beantwortet werden, könnte das laut den pessimistischsten Abschätzungen von de Vries den Energieverbrauch verdreissigfachen – und damit den Gesamtstrombedarf eines kleinen Landes wie Irland überschreiten.

«Ob die Verbindung von Internetsuche mit Sprachmodellen wirklich zu einem Mehrverbrauch führen wird, ist allerdings unklar», sagt Naumann. «Schliesslich könnten bessere Antworten auch dazu führen, dass insgesamt weniger Suchanfragen gestellt werden müssen.» Ausserdem müssten für einen derart grossflächigen Einsatz erst Hunderttausende neue Grafikkarten produziert und installiert werden, was nicht nur einige Jahre dauern würde, sondern nach derzeitigem Stand wohl auch wirtschaftlich unrentabel wäre.

Laut de Vries’ Schätzung würde allein die Anschaffung der zusätzlichen Hardware um die 100 Milliarden Dollar kosten. Selbst aufgeteilt auf drei Jahre würde das in Kombination mit dem zu erwartenden horrenden Zuwachs an Stromkosten den jährlich von Google erwirtschafteten Gewinn fast vollständig auffressen.

Die Lösung könnten ungenauere Modelle sein

Ein Lösungsvorschlag ist, effizientere KI-Modelle zu trainieren. Das verursacht zusätzlichen Aufwand während des Trainings. Aber: «Bei besonders intensiv genutzten Diensten würde sich dieser Aufwand wahrscheinlich lohnen, wenn dafür die Effizienz der einzelnen Anwendungen verbessert wird», meint Naumann. «Ziel muss jedenfalls sein, an jeden Dienst auch eine Art Energie-Preisschild zu hängen.»

Eine weitere Stellschraube, um den Energiehunger von künstlicher Intelligenz zu bändigen, stellt die Genauigkeit der Berechnungen dar.

Zwar laufen KI-Algorithmen schon heute auf Spezialkarten, und Chiphersteller wie Nvidia passen ihre neu entwickelten Chips immer besser an die Ansprüche des maschinellen Lernens an. Im Wesentlichen sind aber auch diese Prozessoren noch für klassische und mathematische Berechnungen konzipiert. «Sie sind präzise und akkurat, so wie wir es eben von Computern gewohnt sind», sagt Professor Ralf Herbrich, der am Hasso-Plattner-Institut (HPI) in Potsdam das Fachgebiet Künstliche Intelligenz und Nachhaltigkeit leitet. «Für KI-Algorithmen, die lediglich Wahrscheinlichkeiten abschätzen, arbeiten sie aber oft viel zu genau und verbrauchen dadurch unnötig viel Energie.»

Dieses Mass an Genauigkeit ist in den Prozessoren fix verdrahtet, weshalb jede noch so kleine Berechnung in der Regel auf 38 Stellen genau durchgeführt wird. «Und zwar auch dann, wenn das Ergebnis am Ende lediglich auf ein Prozent genau vorhersagt, ob auf einem Bild ein Hund oder eine Katze zu sehen ist», gibt Herbrich zu bedenken. In der Grundlagenforschung werde deshalb gegenwärtig untersucht, wie die nötigen Rechenprozesse auch mit geringerer Genauigkeit durchgeführt werden könnten.

Noch hat es genug Strom, aber vielleicht nicht mehr lange

Am HPI in Potsdam arbeiten die Forscher etwa an sogenannten One-Bit-Networks, bei denen die Parameter, die die Verbindungen in einem künstlichen neuronalen Netz beschreiben, lediglich mit einem einzigen Bit anstelle eines kontinuierlichen Wertes dargestellt werden.

«Es gibt dann nur mehr die Information, ob da eine Verbindung ist oder nicht», erklärt Herbrich. «In bestimmten Fällen kann das den Rechenaufwand auf einen Zehntel reduzieren, während die Genauigkeit des Ergebnisses kaum abnimmt, weil sich die Fehler über die vielen Knotenpunkte des Netzes wieder herausmitteln.» Gleichzeitig wird in den Forschungsabteilungen der grossen Chipproduzenten flexible Hardware entwickelt, deren Genauigkeit sich an die Ansprüche der Algorithmen anpassen kann.

«Es ist höchste Zeit, sich intensiv mit den Energiekosten von KI zu beschäftigen», sagt Herbrich. Der Startschuss zum Siegeszug der grossen Sprachmodelle liege bereits fünf Jahre zurück. «Heute haben wir noch genug Strom, aber der Weg von der Grundlagenforschung in die Anwendung ist lang», sagt der Forscher warnend. «Und wenn wir auch in fünf Jahren noch kein Energieproblem haben wollen, müssen wir das jetzt angehen.»